2022年11月30日,一款叫ChatGPT的聊天机器人横空出世,上线仅2个月时间用户数就突破1亿,成为历史上增速最快的应用程序,一夜蹿红,狂飙出圈,继AlphaGo之后再一次掀起了人工智能的技术浪潮。ChatGPT一经问世,便展现出惊人的文字创作能力,上知天文下知地理,写文章、编剧本、敲代码样样都会,甚至还能代写专业论文,解锁了人工智能的无限可能。

大家猛然发现AI原来还可以这样玩,并已迅速进入人们的日常生活。

ChatGPT的能力之源

ChatGPT,全称Chat Generative Pre-trained Transformer,是一种对话生成式预训练模型。罗马不是一天建成的,ChatGPT的“超能力”也不是一夜“炼”成的。说到ChatGPT,就不得不先提GPT(生成式预训练模型),在ChatGPT之前GPT家族已经有三个亲兄弟,个个都是做了无数套各领域知识模拟题的“最强大脑”。

🔹老大GPT-1,2018年6月发布,今年5岁,模型参数量达1亿;

🔹老二GPT-2,2019年2月发布,今年4岁,模型参数量达15亿;

🔹老三GPT-3,2020年5月发布,今年3岁,模型参数量达1750亿。

ChatGPT的亲缘关系与GPT-3最为相近,是基于GPT-3.5架构建立的。

看得出来,每一代GPT模型的参数量都呈爆炸式增长,近期老四GPT-4也发布了,模型参数量可能会更高。参数可以看做是模型里的一个个公式,参数量越大,对应的模型越复杂,做出来的预测就越准确。

小模型就像术业有专攻的专才,针对特定场景做极致优化,方便在边缘和端侧设备部署,但举一反三能力不足,将面临隔行如隔山的“跨行业困境”;大模型犹如全能选手,琴棋书画样样精通,通过学习不同行业、不同场景、不同任务中蕴含的内在逻辑,提供更高质量的内容输出。仅从“能力”考量,固然模型越复杂效果越好,但无限复杂下去并不是“最优解”,反而给数据训练资源、算力软硬件资源、电力资源的消耗都带来了巨大压力,俨然就是一头胃口极大的吞金兽,不利于模型部署和平民化普及。

ChatGPT的未来之路

从参数规模的角度来看,大模型以肉眼可见的速度推动AI技术突飞猛进式提升,短期内,继续增大参数规模和训练数据量仍是技术演进的方向。与参数规模一起飙涨的,还有对计算资源和存储空间的大量需求,因此,在边缘、终端等硬件资源受限的设备上,如何优化模型的计算量和内存需求是未来一段时间需要攻克的难题。

从支持模态的角度来看,我们生活在一个多模态的世界,大脑在感知和理解这个世界的过程中不会只局限于单一模态,而是会结合视觉、听觉、触觉、嗅觉等多个模态共同完成。早期的模型只学习文本等单一模态数据,之后逐步过渡到联合学习文本和图像,再到涵盖文本、图像、语音、视频等多模态数据,不断朝着多模态融合方向发展。

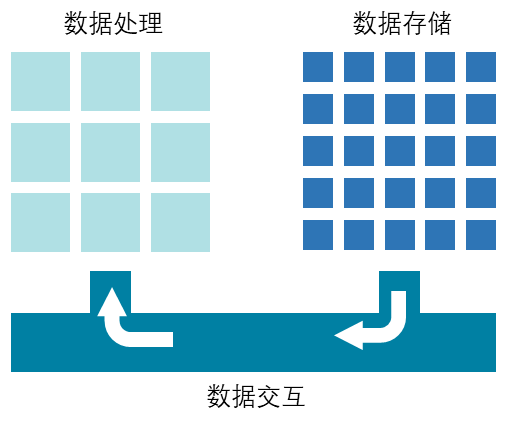

从技术支撑的角度来看,表面上用户在使用ChatGPT完成各项任务,而隐藏在上层应用之下的还有中间层的大模型算法能力和底层的数据计算能力,其中,数据计算能力既没有脱离传统计算,又蕴含着新的计算特质,它围绕着处理、存储、交互三大技术要素演进升级。

冯诺依曼计算架构中的三大技术要素

🔹在数据处理方面,海量的训练数据产生大量的数据处理需求,主要是线性代数运算,不仅对分布式计算能力提出了要求,同时也要求增强专用计算能力,从而在提升运算速度的同时降低功耗。

🔹在数据存储方面,模型运行过程中的数据量很大,对数据存储容量有着巨大需求,要求不断提升片上缓存、片外内存等多级存储介质的存储密度,同时也可以通过减少模型参数量、降低数据精度、数据压缩等方式来缓解需求。

🔹在数据交互方面,计算单元和存储单元间海量的数据交互,要求具有大带宽、低时延的访存能力,模型参数的数据本地化特征较强,适合数据复用和近内存计算,对HBM(高带宽内存芯片)、DPU(专用数据处理器)、存算一体芯片提出了需求。

对此,奕斯伟计算CTO表示:“ChatGPT等大语言模型(LLM)的突破性进展加速了通用人工智能(AGI)演进,对计算技术提出了更高要求,它的热潮将加速芯片技术的创新和升级,从芯片架构、算法优化、软件支持、功耗控制等多方面实现提升。芯片厂商除了关注单一技术或算力指标,更要注重产品的综合竞争力是否均衡,要根据具体场景定义产品,结合应用发展技术,以芯片为核心,综合考量计算、存储、网络三方面因素,打造软硬件深度优化的系统级整体解决方案。”

原文始发于微信公众号(奕斯伟计算):技术奕谈 | ChatGPT是怎样“炼”成的?